Термин halting problem обычно вспоминают как «ту самую» теоретическую границу вычислений: нельзя написать программу, которая для любой другой программы и любого входа заранее решит, завершится ли вычисление или уйдёт в бесконечный цикл. Но если посмотреть на индустриальные системы — от микросервисов до агентных пайплайнов с LLM — то «проблема остановки» неожиданно перестаёт быть абстракцией. Она проявляется как практический конфликт требований, архитектурных допущений и операционных метрик.

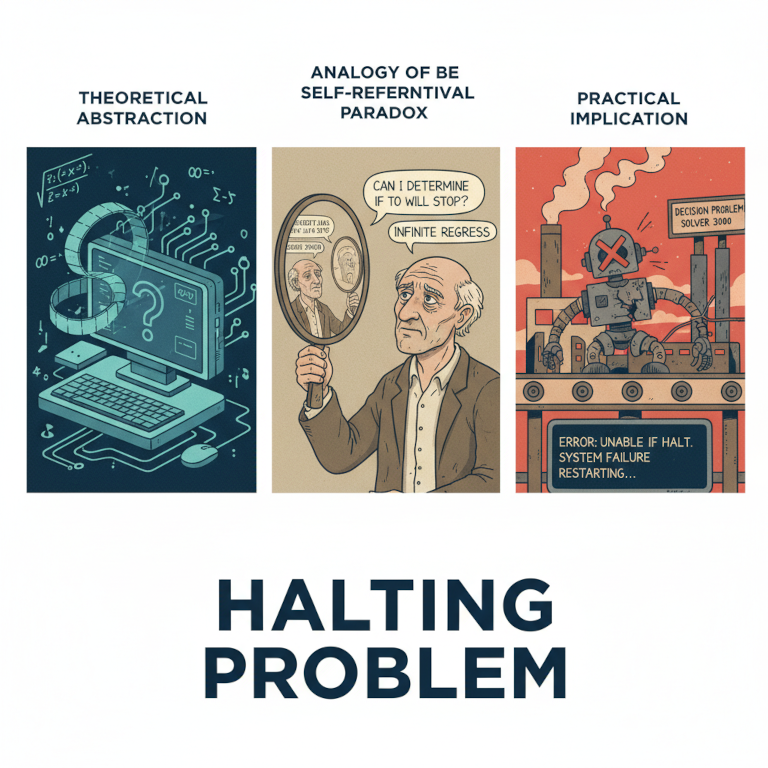

Ниже — три «ипостаси» halting problem: классическая (про отдельный вычислительный узел), распределённая (про прогресс и безопасность в распределенной системе) и модная-молодежная ИИ-агентная (про циклы рассуждений, инструменты и галлюцинации). В каждой из них речь не только о математическом факте, но и о том, как инженеры вынуждены проектировать системы вокруг невозможности гарантированно знать и контролировать останов.

Классика: один компьютер, одна программа, одна невозможность

В формулировке Тьюринга у нас есть программа и вход . Хотим алгоритм HALT(P, x), который возвращает true, если остановится, и false, если будет выполняться бесконечно. Оказывается, такого алгоритма в общем случае не существует. И это не «мы пока не нашли», а «не может существовать».

Инженерный смысл этой теоремы часто недооценивают. Она говорит не просто «есть сложные случаи». Она говорит: в мире программ существуют корректные, конечные по размеру описания вычислений, для которых нельзя построить универсальный предсказатель завершения. Даже если вы очень умны, даже если у вас бесконечно быстрый компьютер — универсального решения нет.

На практике мы, конечно, постоянно «решаем проблему остановки», но всегда ценой ограничения постановки:

- ограничиваем язык (например, тотально-функциональные подмножества, структурная рекурсия);

- ограничиваем программу (например, «только без циклов», «только с bounded loops»);

- вводим таймаут (подмена «остановится ли?» на «успеет ли за T?»);

- используем статический анализ и SMT/abstract interpretation, которые дают неполные результаты: иногда скажут «точно не остановится», иногда «точно остановится», а иногда честно «не знаю».

То есть классическая ипостась halting problem — это напоминание: про завершение в общем случае нельзя иметь идеального оракула. Дальше становится интереснее: в распределённых системах «остановка» перестаёт быть свойством одной программы и становится свойством протокола и среды.

Распределённые системы: halting problem как отсутствие прогресса

Если перейти от одного узла к распределённой системе, то интуитивно кажется: «ну хорошо, один узел может зависнуть, но остальные-то живы». Однако с точки зрения пользователя важен не факт, что какой-то сервер крутит CPU, а то, что система делает прогресс: отвечает, принимает решения, фиксирует состояние.

В распределённых алгоритмах есть два фундаментальных свойства, которые удобно рассматривать парой — progress и safety. Есть хорошая статья у Уве про eventual consistency, в которой он формулирует их конфликт очень ёмко:

- прогресс: Better an approximate answer in time than a perfect answer that never arrives. — Лучше приблизительный ответ во время чем точный ответ, который никогда не придёт.

- безопасность/точность (safety): Better no answer at all than a non-exact answer. — Лучше совсем без ответа чем неточный ответ.

Смысл в том, что under adverse conditions (сеть шалит, узлы падают, задержки растут) система почти всегда вынуждена выбирать, какое свойство «сдать» первым.

Progress vs Safety в распределённых системах

И вот здесь появляется распределённая версия «остановки»: система может быть «живой» на уровне процессов, но «остановившейся» на уровне спецификации прогресса. Например:

- Сервис принимает запросы, но транзакции не коммитятся, потому что недоступен кворум.

- Лидер в консенсусе не может быть избран из-за длительной сетевой партиции или асимметричных задержек.

- Очередь сообщений продолжает принимать события, но потребители не подтверждают обработку (backpressure, poison messages), и «конечный» эффект никогда не наступает.

В таких случаях причина «halt» распределённой системы не обязана быть «halt на конкретном узле». Часто узлы работают как положено — просто невозможно доказать достаточные условия для безопасного шага, не нарушив safety. Если система выбирает safety, она может законно «ничего не делать» бесконечно долго, ожидая восстановления условий. Формально это может быть корректно, но для бизнеса и пользователей это выглядит как зависание.

Если система, напротив, выбирает прогресс, она будет отвечать и двигаться вперёд, но может отдавать приближённые или временно неконсистентные ответы — eventual consistency в этом смысле не «лотерея», а явная политика: пусть будет временная несогласованность, зато будет движение.

Получается характерная инженерная «троица» решений вместо невозможного идеала:

- Принять зависание (safety-first): не отвечаем, пока не можем ответить точно.

- Принять приближение (progress-first): отвечаем быстро, потом сходимся.

- Ограничить задачу: ввести SLA, таймауты, деградацию, отказ от части гарантий.

И это уже очень похоже на классический halting problem: универсальной процедуры, которая всегда и заранее скажет «система завершит обработку запроса корректно и вовремя», — нет. В распределённом мире «вовремя» зависит от сети и отказов, а «корректно» зависит от выбранных гарантий.

Агентные системы с LLM: остановка как ускользающий контур управления

Теперь добавим модный слой — ИИ-агентов. Типовая агентная система выглядит как распределённая: есть оркестратор, один или несколько агентов, внешние инструменты (поиск, базы, код-раннер, браузер, таск-трекер), очереди задач, память/контекст, наблюдаемость. И в центре — LLM, которая генерирует действия, планы, вызовы тулов и интерпретирует результаты.

Здесь «проблема остановки» проявляется сразу по нескольким линиям.

Циклы «подумал → вызвал инструмент → подумал»

Агент часто устроен как цикл: пока задача не решена, выбирай следующий шаг. Но критерий «решена» обычно не является строгой формальной проверкой; это эвристика, классификатор, self-evaluation или вообще «кажется, готово». В результате возникают режимы:

- бесконечные уточнения («нужно ещё проверить один источник»);

- «tool ping-pong» — агент вызывает инструменты, получает неоднозначный результат и снова вызывает;

- деградация контекста: чем больше итераций, тем выше шанс потерять исходные требования и начать оптимизировать не то.

Это похоже на классическую проблему: мы не можем построить универсальный критерий, который гарантированно остановит «правильный» процесс рассуждений на оптимальном шаге.

Галлюцинации как нарушение safety, а стоп-сигналы как удар по progress

В агентных системах safety — это не только консистентность данных, но и истинность утверждений, корректность действий и соответствие политике. Галлюцинация может быть эквивалентом «некорректного состояния» в распределённом протоколе: система продолжает «делать прогресс», но движется в неправильном направлении.

Если вы усиливаете safety (жёсткие валидации, требование источников, строгие схемы, запрет «додумывать»), вы рискуете потерять progress: агент будет часто упираться в «не могу подтвердить» и зависать в повторных попытках найти доказательства, переформулировать запрос, опросить другие инструменты.

Если вы усиливаете progress (разрешаете отвечать «по смыслу», снижаете порог уверенности, сокращаете верификацию), вы рискуете выдать быстрый, но неверный результат.

И снова тот же конфликт: лучше приблизительно, но вовремя — или лучше молчать, чем ошибиться.

«Остановка» становится управленческой проблемой

В агентной системе важнее не философский вопрос «завершится ли алгоритм», а вопрос управления контуром:

- какие есть лимиты на число итераций;

- какие таймауты на инструменты и на весь эпизод;

- какие условия раннего выхода (good enough);

- какие условия аварийного выхода (слишком много одинаковых попыток, деградация качества, подозрение на зацикливание);

- какие проверки результата (валидаторы, тесты, сравнение с источниками).

То есть мы лечим halting problem так же, как и в классике: не «решаем», а обрезаем пространство случаев, вводим бюджеты и формализуем критерии приемлемости.

Вместо вывода: три ипостаси, один мотив

По классике CS halting problem говорит: невозможно иметь универсальный предсказатель завершения программы. В распределённых системах «остановка» переезжает с одного процесса на свойства алгоритма под отказами и задержками и проявляется как потеря прогресса при сохранении safety (или наоборот). В агентных системах добавляется ещё один источник неопределённости: модель, которая может ошибаться, зацикливаться и принимать решения на основе неполной верификации.

Общий мотив один: в реальных системах мы постоянно выбираем между прогрессом и безопасностью и постоянно пытаемся «вырезать» бесконечность через лимиты, таймауты, деградации и проверяемые инварианты. Мы не отменяем теорему Тьюринга — мы строим инженерные рамки, в которых остановка становится не доказуемой гарантией, а управляемым риском.